神经网络高维互信息计算Python实现(MINE)

论文 Belghazi, Mohamed Ishmael, et al. “Mutual information neural estimation.” International Confer…

论文 Belghazi, Mohamed Ishmael, et al. “Mutual information neural estimation.” International Confer…

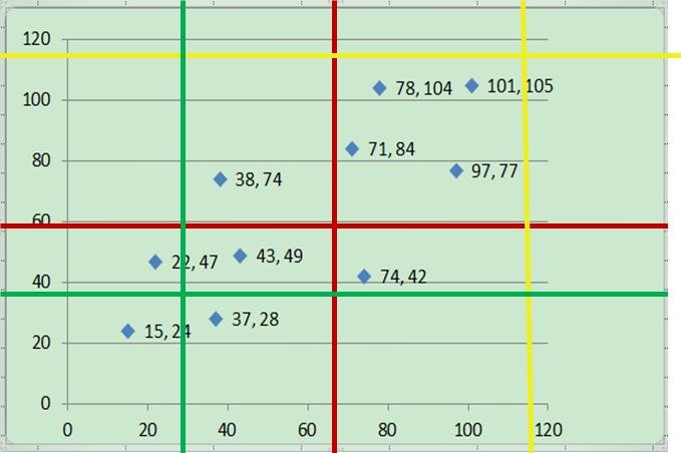

在做特征选择时,可能面临两个问题:特征与类别预测有多大相关性,特征之间有多大冗余度。在特征选择中,“…

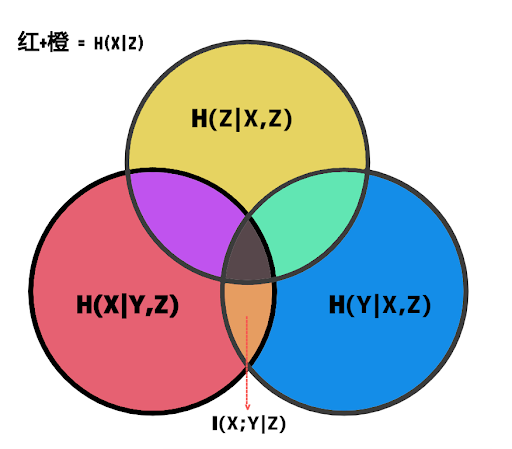

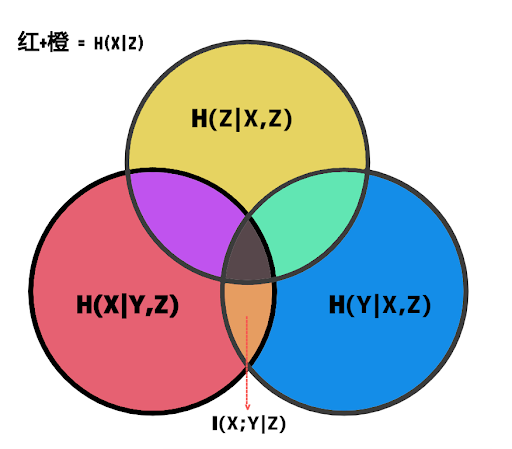

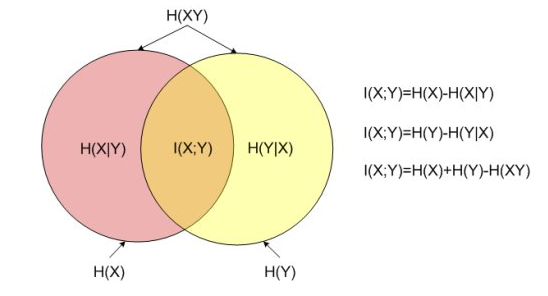

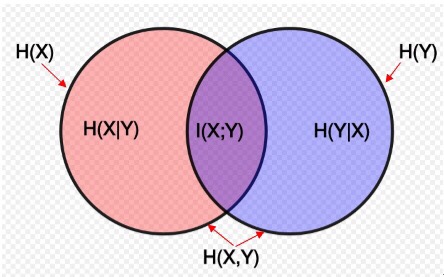

互信息的定义 正式地,两个离散随机变量 X 和 Y 的互信息可以定义为: 其中 p(x,y) 是 X 和 Y 的联合概率…

在概率论和信息论中,两个随机变量的互信息(Mutual Information,简称MI)或转移信息(transinformation…

在概率论和信息论中,两个随机变量的互信息(Mutual Information,简称MI)或转移信息(transinformation…

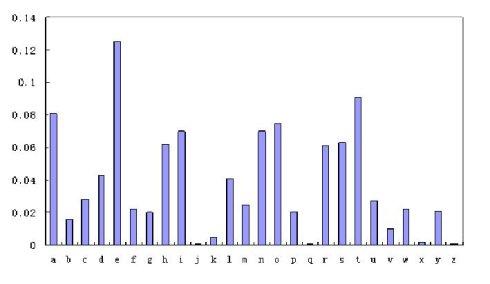

26个英文字母在平均出现时的信息熵是4.7BIT,而去掉冗余度后的英文字母的信息熵是4.03BIT。 公式: H(信息熵…

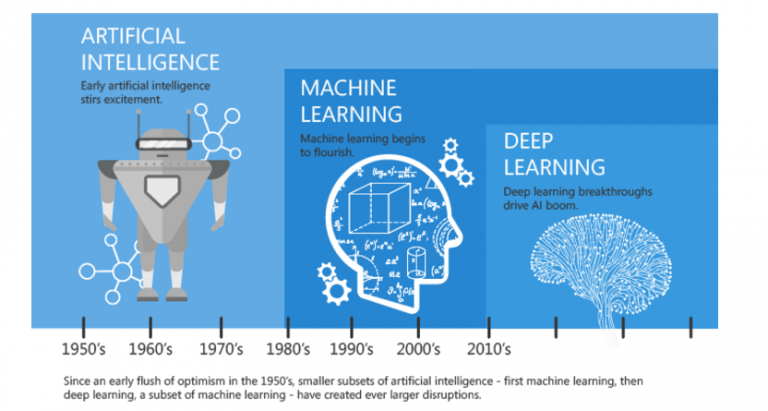

简介 1948 年,香农提出了“信息熵”(Shannon entropy/Information entropy) 的概念,才解决了对信息的量化…

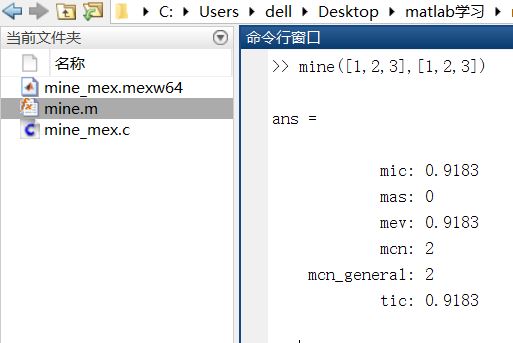

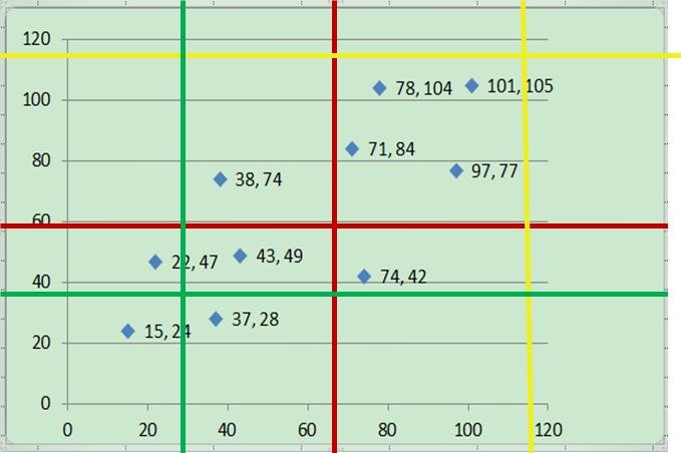

最大信息系数 maximal information coefficient (MIC),又称最大互信息系数。 之前写了一个MIC的介绍,里…

最大信息系数 maximal information coefficient (MIC),又称最大互信息系数。 之前写了一个MIC的介绍,里…

最大信息系数 maximal information coefficient (MIC),又称最大互信息系数 目的:Maximal Information Co…